Una tecnica d’intelligenza artificiale generativa aumenta considerevolmente le capacità dei robot con una metodologia che fa risparmiare sulla programmazione.

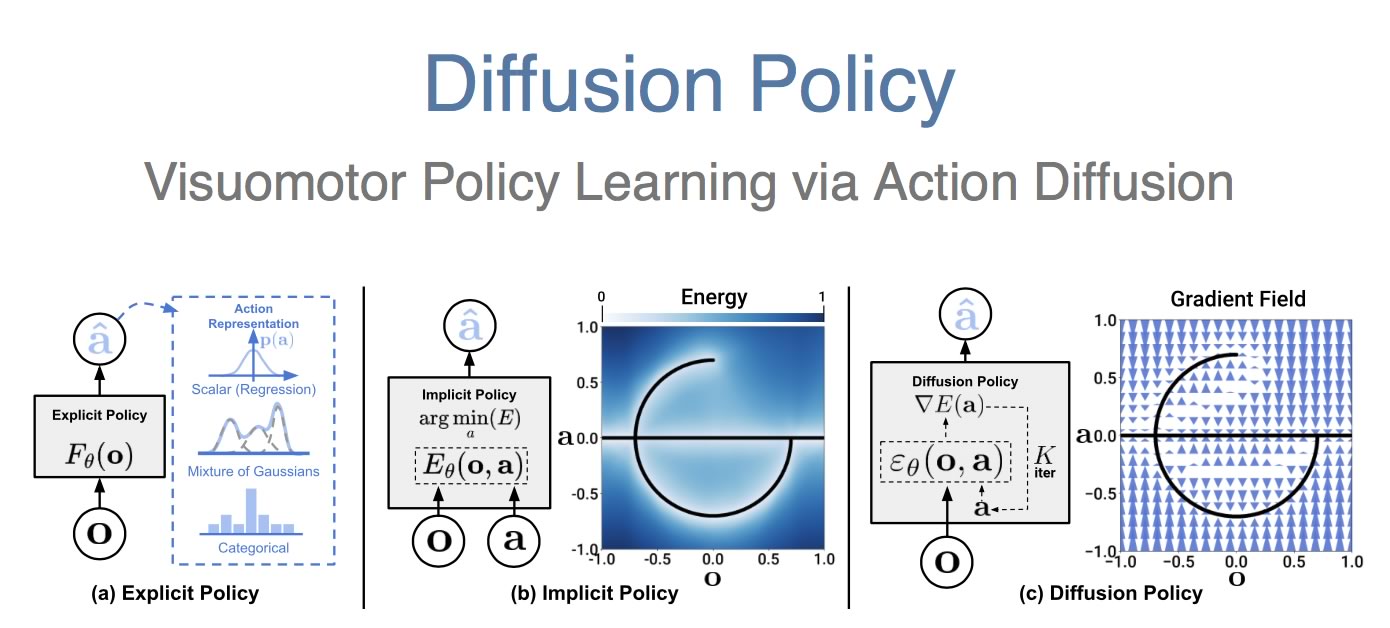

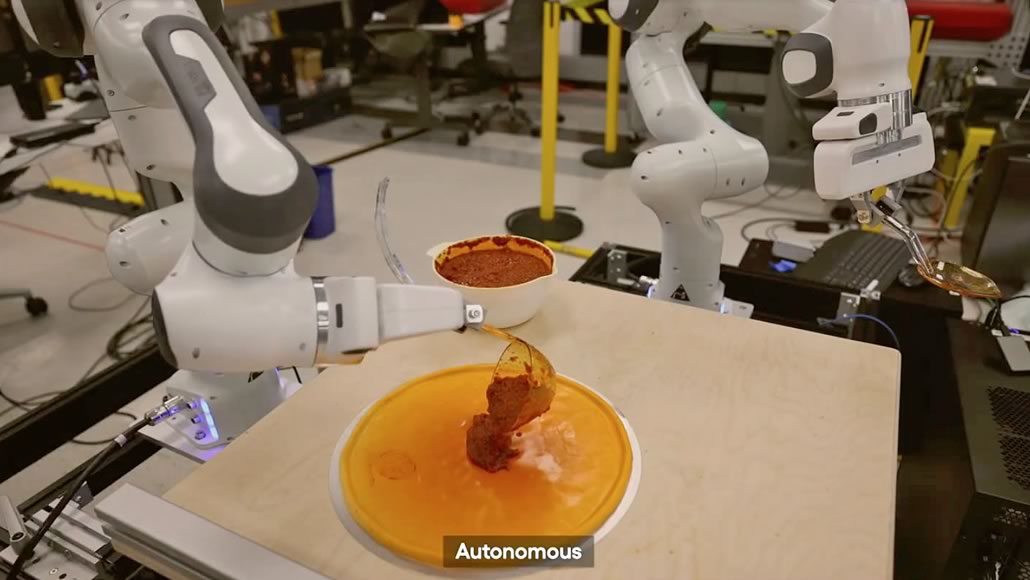

Il 19 settembre 2023, il Toyota Research Institute (TRI) ha annunciato un approccio rivoluzionario nella robotica basato sulla Visuomotor Policy Learning via Action Diffusion ossia l’apprendimento del coordinamento della percezione visiva e dei movimenti risultante da un processo di denoising diffusion.

Gill Pratt, CEO di TRI e Chief Scientist di Toyota Motor Corporation, ha dichiarato come la ricerca nel campo della robotica miri ad amplificare le persone piuttosto che a sostituirle.

Le precedenti tecniche per automi erano lente, incoerenti, inefficienti e spesso limitate a compiti strettamente definiti, eseguiti in ambienti altamente vincolati. Gli specialisti dovevano trascorrere molte ore scrivendo codici complicati e/o utilizzando numerosi cicli di tentativi ed errori per programmare i comportamenti.

La novità usa una potente tecnica d’intelligenza artificiale generativa chiamata diffusion policy che consente d’insegnare ai robot molto più rapidamente e con un numero decisamente inferiore di dimostrazioni.

Russ Tedrake, vicepresidente della ricerca sulla robotica presso TRI e professore d’ingegneria elettrica e informatica, aeronautica, astronautica e meccanica al MIT, ha spiegato come sia entusiasmante vedere la velocità e l’affidabilità con cui si possono aggiungere nuove competenze. Queste abilità funzionano attraverso le immagini della telecamera ed il rilevamento tattile, sfruttando rappresentazioni apprese per svolgere compiti che coinvolgono oggetti deformabili, tessuti e liquidi, tutti tradizionalmente difficili da gestire per i robot.

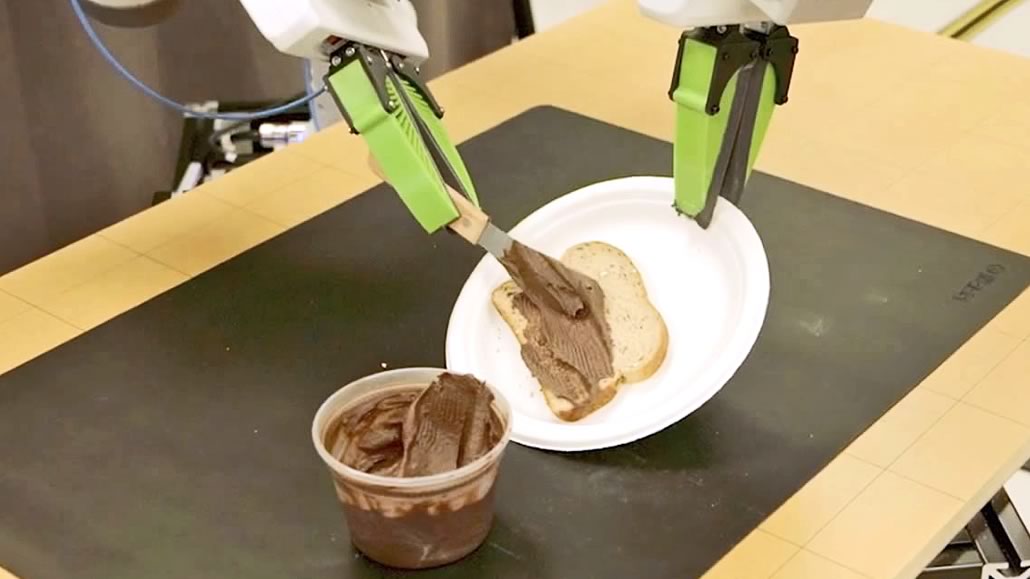

Ben Burchfiel (Manager Dexterous Manipulation) ha detto come finora la maggior parte del lavoro sulla manipolazione sia stato su azioni in stile Pick & Place dove un robot è limitato ad insiemi di oggetti relativamente semplici.

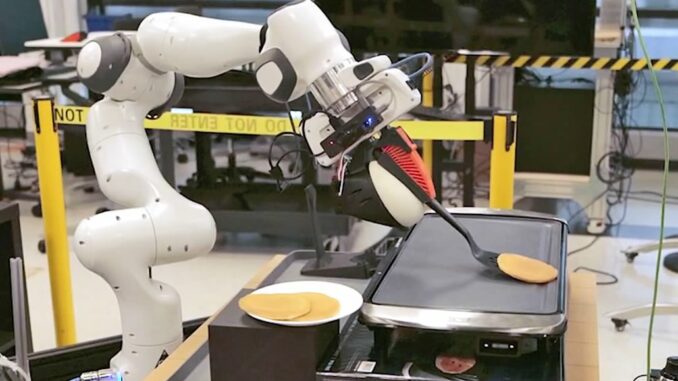

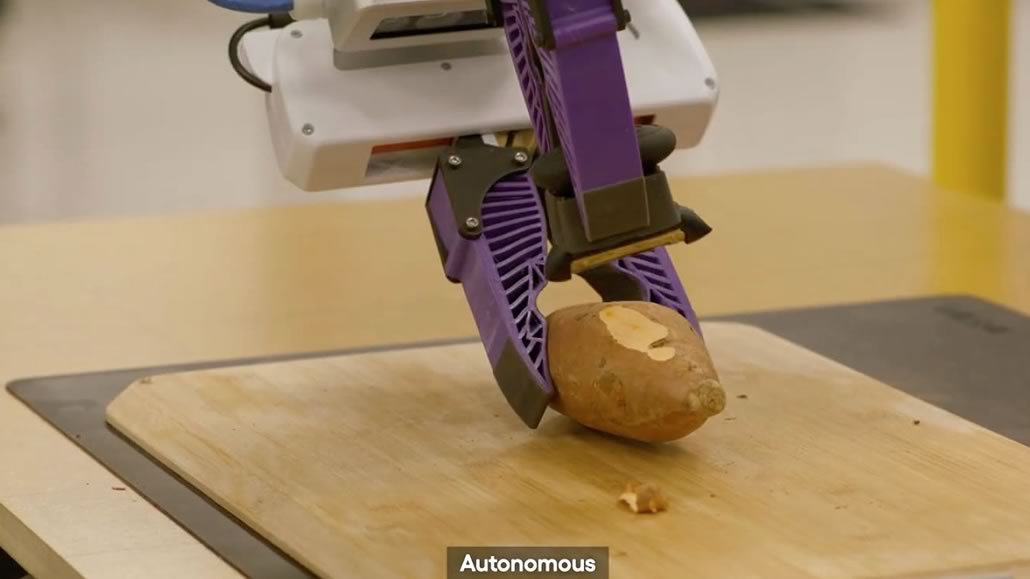

I robot di TRI sono ora capaci di utilizzare strumenti per versare liquidi e sbucciare verdure.

Per i ricercatori è emozionante vederli interagire con l’ambiente in maniere ricche di sfaccettature, obiettivi raggiunti senza modificare alcun codice o programmare esplicitamente funzioni. Gli scienziati sono riusciti ad insegnare oltre 60 comportamenti diversi impiegando questa metodologia.

Il processo inizia con un istruttore che dà la dimostrazione di una piccola serie di competenze attraverso la teleoperatività, poi la diffusion policy, sviluppata da TRI in collaborazione con Columbia University e MIT, fa apprendere in background nel giro di poche ore. Normalmente s’insegna nel pomeriggio per lasciar elaborare durante la notte e rientrare la mattina dopo trovando un nuovo comportamento funzionante. Ogni parte della piattaforma deve essere affidabile, dall’hardware fino all’intero stack software (componenti indipendenti che lavorano insieme per eseguire un’applicazione, ndr).

Un fattore chiave è fornire il senso del tatto o un dispositivo teleop tattile. Un esempio perfetto è il compito di girare una frittella dove l’apparecchio deve entrare in contatto con la superficie che non può vedere. Senza la percezione tattile fatica agendo male, invece sentendo la sua interazione con l’ambiente, assimila la pratica.

Questo è solo l’inizio. Il team è concentrato sul raggiungimento di modelli comportamentali di grandi dimensioni. Burchfiel prevede che la prossima svolta avverrà quando si addestreranno i robot ad abilità generalizzate eseguendo compiti non mostrati. Il laboratorio sta preparando un curriculum diversificato, una sorta di scuola materna per automi dove trasmettere le competenze fondamentali per lavorare a fianco delle persone.

Entro fine 2023 il TRI dovrebbe riuscire ad insegnare centinaia di nuovi comportamenti, superando le migliaia entro la fine del 2024, mettendo a frutto l’esperienza maturata nella simulazione oltre a sviluppare strumenti per far sì che quanto apprenda un robot sia acquisito da tutti gli altri. Solo un anno fa sembrava incredibile arrivare ad un tale progresso.

Il progetto è stato elaborato con Drake che ha fornito tool e piattaforma all’avanguardia con un alto grado di realismo nelle simulazioni, oltre ad uno stack di sicurezza per rispettare gli standard ed evitare collisioni.

Nel video, allegato alla documentazione scientifica, si vedono le fasi di miglioramento. Un significativo passo in avanti verso “Large Behavior Models (LBM)” analoghi ai Large Language Models (LLM) che hanno recentemente rivoluzionato l’intelligenza artificiale convenzionale.

RIPRODUZIONE RISERVATA – © 2023 SHOWTECHIES – Quando la Tecnologia è spettacolo™ – E’ vietata la riproduzione e redistribuzione, anche parziale, dell’articolo senza autorizzazione scritta. Se desideri riprodurre i contenuti pubblicati, contattaci.

Immagini: TRI (Toyota Research Institute)

Commenta per primo